Nachrichten

Intel Gaudi 2 KI-Beschleuniger können Text mit Llama 2-Modellen mit bis zu 70 Milliarden Parametern generieren

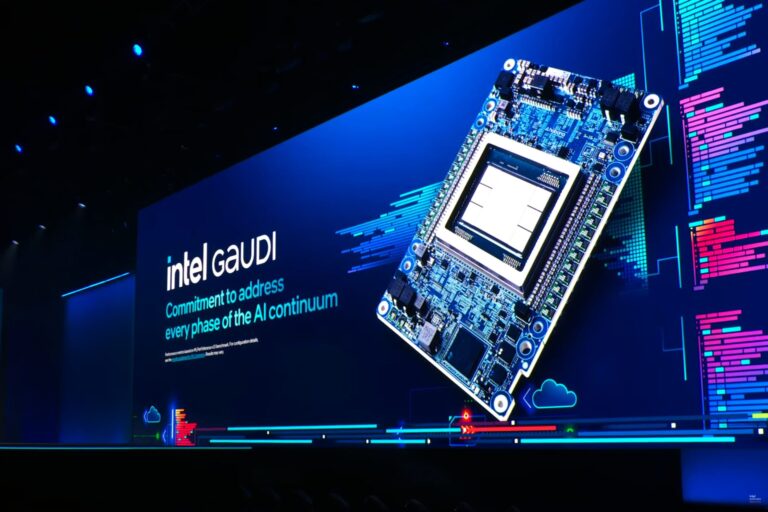

Intels Gaudi 2 KI-Beschleuniger sind die praktischste Alternative zu NVIDIAs Chips und Hugging Face hat seine Fähigkeit zur Textgenerierung mit Llama 2 unter Beweis gestellt.

Intel Gaudi 2-Beschleuniger werden bei der Textgenerierung mit Open-Source-Llama-2-LLMs mit bis zu 70 Milliarden Parametern vorgeführt

Während Intel sein KI-Software-Ökosystem erweitert, zielt das Unternehmen auf die beliebtesten KI-Workloads ab, zu denen auch LLMs (Large Language Models) gehören. Die Arbeit wird ermöglicht durch Habana Optimum die als Schnittstellentransformatoren und Diffusoren für Bibliotheken und die Intel Habana Gaudi-Prozessoren wie Gaudi 2 dient. Das Unternehmen hat dies bereits getan gezeigt Die KI-Fähigkeiten und die Leistung seiner Gaudi 2-Prozessoren im Vergleich zu NVIDIAs A100-GPUs, die eine der beliebtesten Optionen auf dem Markt sind, aber Gaudi 2 leistet eine lobenswerte Arbeit, indem es eine schnellere Leistung zu wettbewerbsfähigen Gesamtbetriebskosten bietet.

Für die neueste Demonstration zeigt Hugging Face, wie einfach die Textgenerierung mit Llama 2 (7b, 13b, 70b) unter Verwendung derselben Optimum Habana-Pipeline und des Intel Gaudi 2 AI-Beschleunigers ist. Das Endergebnis zeigt, dass der Gaudi 2-Chip nicht nur einzelne/mehrere Eingabeaufforderungen akzeptieren konnte, sondern auch sehr einfach zu verwenden war und auch benutzerdefinierte Plugins innerhalb von Skripten verarbeiten konnte.

Da die Revolution der generativen KI (GenAI) in vollem Gange ist, ist die Textgenerierung mit Open-Source-Transformatormodellen wie Llama 2 zum Stadtgespräch geworden. Sowohl KI-Enthusiasten als auch Entwickler möchten die generativen Fähigkeiten solcher Modelle für ihre eigenen Anwendungsfälle und Anwendungen nutzen. Dieser Artikel zeigt, wie einfach es ist, mit der Llama 2-Modellfamilie (7b, 13b und 70b) mithilfe von Optimum Habana und einer benutzerdefinierten Pipeline-Klasse Text zu generieren – Sie können die Modelle mit nur wenigen Codezeilen ausführen!

Diese benutzerdefinierte Pipeline-Klasse wurde entwickelt, um große Flexibilität und Benutzerfreundlichkeit zu bieten. Darüber hinaus bietet es ein hohes Maß an Abstraktion und führt eine durchgängige Textgenerierung durch, die eine Vor- und Nachbearbeitung umfasst. Es gibt mehrere Möglichkeiten, die Pipeline zu verwenden – Sie können die ausführen

run_pipeline.pySkript aus dem Optimum Habana-Repository, fügen Sie die Pipeline-Klasse zu Ihren eigenen Python-Skripten hinzu oder initialisieren Sie LangChain-Klassen damit.Wir haben eine benutzerdefinierte Textgenerierungspipeline auf dem Intel Gaudi 2 AI-Beschleuniger vorgestellt, die einzelne oder mehrere Eingabeaufforderungen als Eingabe akzeptiert. Diese Pipeline bietet große Flexibilität hinsichtlich der Modellgröße sowie der Parameter, die sich auf die Qualität der Textgenerierung auswirken. Darüber hinaus ist es sehr einfach zu verwenden und in Ihre Skripte einzubinden und mit LangChain kompatibel.

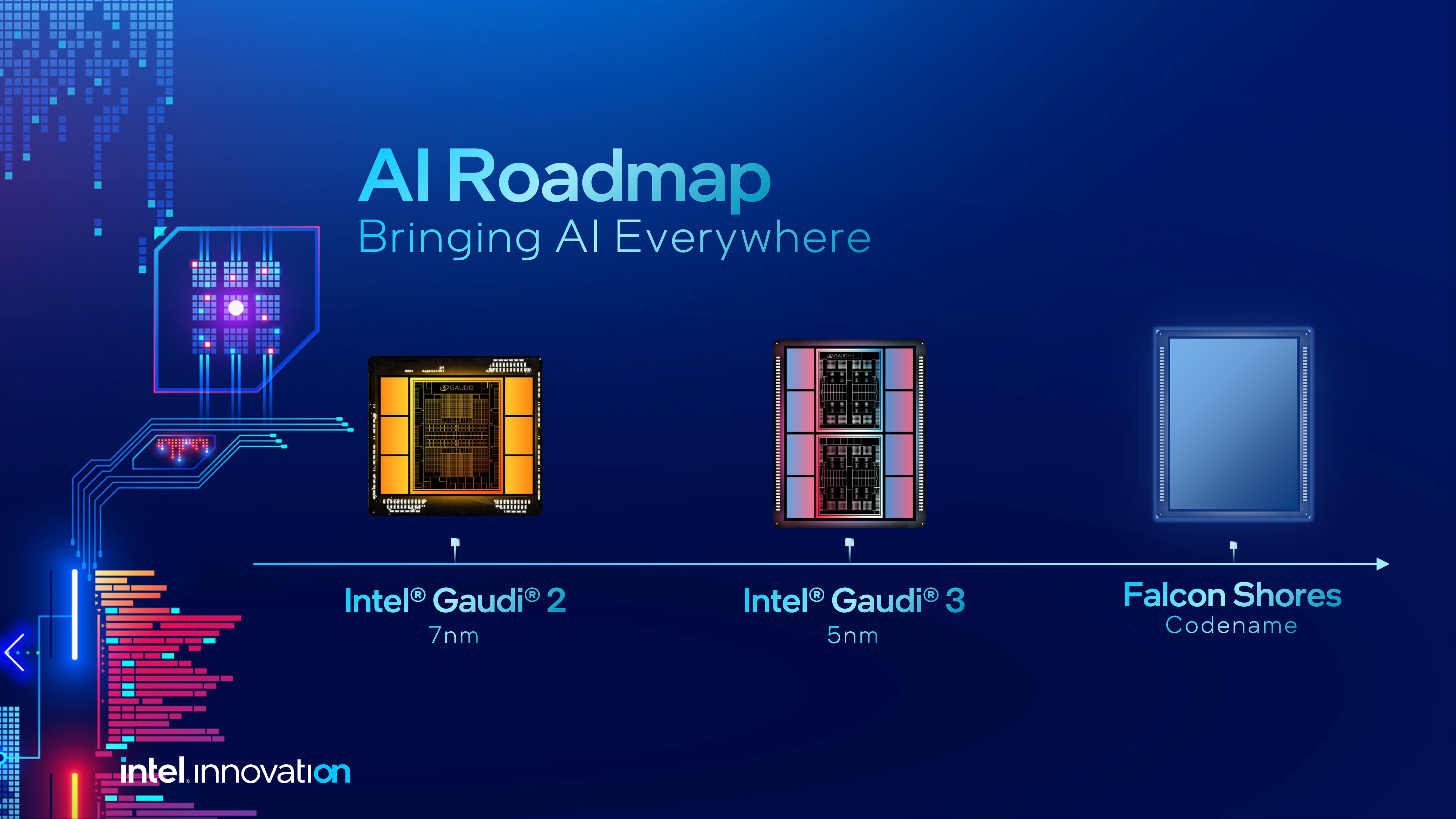

Intel ist bestrebt, sein KI-Segment in den kommenden Jahren voranzutreiben. In diesem Jahr plant das Unternehmen die Einführung der dritten Iteration von Gaudi, bekannt als Gaudi 3, die voraussichtlich einen 5-nm-Prozessknoten verwenden wird und angeblich schneller als der NVIDIA H100 ist, und das zu einem deutlich niedrigeren Preis. In ähnlicher Weise plant das Unternehmen auch, mit der Falcon Shores-GPU der nächsten Generation auf ein vollständig eigenes Design umzusteigen, was für 2025 erwartet wird. Das Unternehmen eröffnet auch KI-Funktionen wie die Llama 2-Schnittstelle mit PyTorch für seine Consumer-GPUs der Arc A-Serie.