Nachrichten

Micron beginnt mit der HBM3e-Volumenproduktion, die ihr Debüt in den H200-KI-GPUs von NVIDIA geben wird

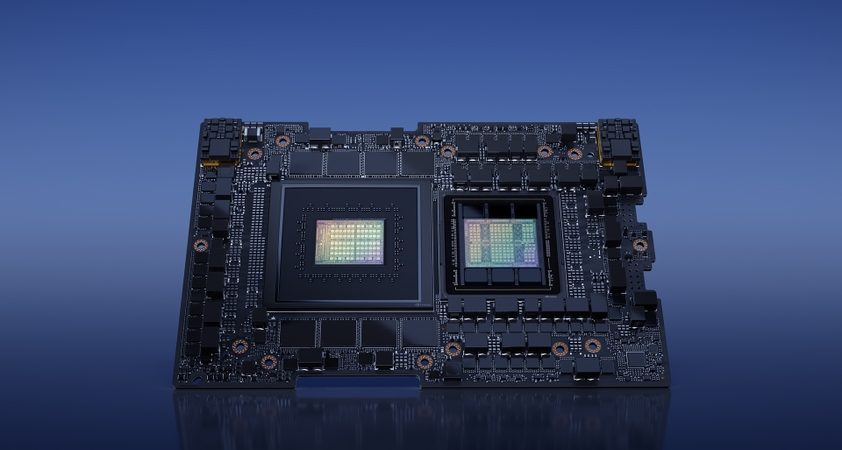

Micron hat mit der Massenproduktion davon begonnen HBM3e-Speicherda der Standard von Firmen wie NVIDIA für H200-KI-GPUs massenhaft übernommen wird.

Die HBM3e-Lösung von Micron verspricht außergewöhnliche Leistung, trägt dem Wachstum von KI-Lösungen Rechnung und treibt NVIDIAs H200-KI-Juggernaut an

[Press Release]: Micron Technology gab heute bekannt, dass es mit der Massenproduktion seiner HBM3E-Lösung (High Bandwidth Memory 3E) begonnen hat. Microns 24 GB 8H HBM3E wird Teil der NVIDIA H200 Tensor Core GPUs sein, deren Auslieferung im zweiten Kalenderquartal 2024 beginnt.

Dieser Meilenstein positioniert Micron an der Spitze der Branche und ermöglicht Lösungen für künstliche Intelligenz (KI) mit der branchenführenden Leistung und Energieeffizienz von HBM3E. Da die Nachfrage nach KI weiter steigt, ist der Bedarf an Speicherlösungen, die mit den zunehmenden Arbeitslasten Schritt halten können, von entscheidender Bedeutung.

Die HBM3E-Lösung von Micron begegnet dieser Herausforderung direkt mit:

- Überlegene Leistung: Mit einer Pin-Geschwindigkeit von mehr als 9,2 Gigabit pro Sekunde (Gb/s) liefert der HBM3E von Micron mehr als 1,2 Terabyte pro Sekunde (TB/s) Speicherbandbreite und ermöglicht so einen blitzschnellen Datenzugriff für KI-Beschleuniger, Supercomputer und Daten Zentren.

- Außergewöhnliche Effizienz: HBM3E ist branchenführend mit einem um etwa 30 % geringeren Stromverbrauch im Vergleich zu Konkurrenzangeboten. Um die steigende Nachfrage und Nutzung von KI zu unterstützen, bietet HBM3E maximalen Durchsatz bei niedrigstem Stromverbrauch, um wichtige Betriebskostenkennzahlen für Rechenzentren zu verbessern.

- Nahtlose Skalierbarkeit: Mit einer Kapazität von heute 24 GB ermöglicht HBM3E Rechenzentren die nahtlose Skalierung ihrer KI-Anwendungen. Ob zum Training riesiger neuronaler Netze oder zur Beschleunigung von Inferenzaufgaben, die Lösung von Micron stellt die nötige Speicherbandbreite bereit.

Micron hat dieses branchenführende HBM3E-Design mithilfe seiner 1-Beta-Technologie, fortschrittlicher Through-Silicon Via (TSV) und anderen Innovationen entwickelt, die eine differenzierte Verpackungslösung ermöglichen. Micron, ein bewährter Marktführer im Bereich Speicher für 2,5D/3D-Stacking und fortschrittliche Verpackungstechnologien, ist stolz darauf, Partner der 3DFabric Alliance von TSMC zu sein und die Zukunft von Halbleiter- und Systeminnovationen mitzugestalten.

Micron liefert mit diesem HBM3E-Meilenstein ein Dreifaches: Marktführerschaft bei der Markteinführung, erstklassige Branchenleistung und ein differenziertes Energieeffizienzprofil. KI-Workloads hängen stark von der Speicherbandbreite und -kapazität ab, und Micron ist mit unserer branchenführenden HBM3E- und HBM4-Roadmap sowie unserem vollständigen Portfolio an DRAM- und NAND-Lösungen für KI-Anwendungen sehr gut positioniert, um das bevorstehende bedeutende KI-Wachstum zu unterstützen.

– Sumit Sadana, Executive VP und Chief Business Officer bei Micron Technology

Micron baut seine Führungsposition außerdem mit der Bemusterung des 36 GB 12-High HBM3E aus, das im März 2024 eine Leistung von mehr als 1,2 TB/s und eine überlegene Energieeffizienz im Vergleich zu Konkurrenzlösungen bieten soll. Micron ist Sponsor bei NVIDIA GTC. Eine globale KI-Konferenz beginnt am 18. März, auf der das Unternehmen mehr über sein branchenführendes KI-Speicherportfolio und seine Roadmaps berichten wird.

Nachrichtenquelle: Mikron