Nachrichten

Qualcomm AI Hub auf dem MWC 2024 veröffentlicht; Führen Sie KI-Modelle auf Ihrem Gerät aus

Auf dem MWC 2024 hat Qualcomm endlich seinen AI Hub vorgestellt, um On-Device-KI-Erlebnisse auf mehreren Geräten bereitzustellen. Der amerikanische Chiphersteller sagt, seine KI-Engine sei leistungsstark genug, um intelligentes Computing auf allen Plattformen anzubieten, vom Smartphone bis zum PC.

Qualcomm AI Hub verfügt über eine Bibliothek vollständig optimierter KI-Modelle, die Sie herunterladen und lokal auf Ihrem Gerät ausführen können. Es unterstützt auch viele beliebte KI-Frameworks wie TensorFlow von Google und PyTorch von Meta AI als Teil des Qualcomm AI Stack.

Qualcomm AI Hub hat über 75 KI-Modelle optimiert

Qualcomm gibt an, dass sein AI Hub dies getan hat über 75 optimierte KI-Modelle und unterstützt KI-Inferenz bis zu 4-mal besser als die Konkurrenz. Sie können diese KI-Modelle für verschiedene Aufgaben verwenden, darunter Bildsegmentierung, Bildgenerierung, Textgenerierung, Verbesserung bei schlechten Lichtverhältnissen, Superauflösung, Spracherkennung und mehr. Gleichzeitig kann der Qualcomm AI Hub multimodale KI-Modelle betreiben, die lokal sehen, hören und sprechen können.

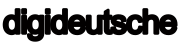

Der Chipriese erwähnte, dass dies möglich sei Führen Sie multimodale KI-Modelle aus mit 7B+ Parametern auf Android-Geräten lokal. Es kann Modelle wie LLaVa mit Unterstützung für Text-, Sprach- und Bildausgabe ausführen. Der gesamte Software-Stack wurde optimiert, um die beste KI-Leistung bei minimalem Stromverbrauch zu liefern. Da alles vor Ort erledigt wird, ist Ihr die Privatsphäre bleibt gewahrtund es schaltet auch personalisierte KI-Erlebnisse frei.

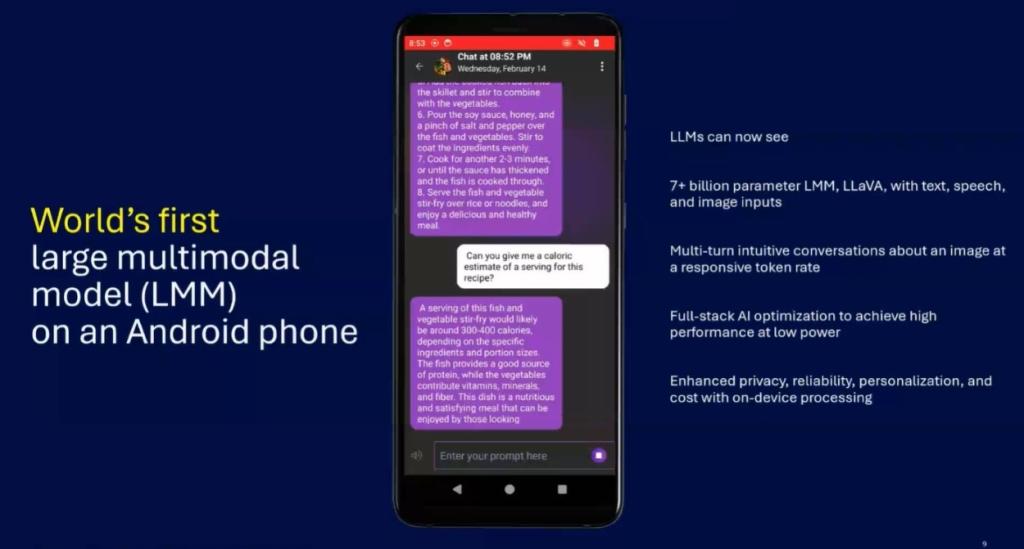

Sogar auf Windows-Laptops mit dem kommenden Snapdragon Qualcomm hat auch eine Technik namens eingesetzt LoRA (Low-Rank Adaptation) zur Generierung von KI-Bildern Verwenden von Stable Diffusion lokal auf dem Gerät. Es kann das Stable-Diffusion-Modell mit 1B+-Parametern ausführen.

Qualcomm vs. Intel: NPU-Leistung

Um die leistungsstarke On-Device-KI-Fähigkeit von Snapdragon Der mit dem Snapdragon X Elite betriebene Laptop erzeugte ein KI-Bild nur 7,25 Sekunden wohingegen der neueste x86-basierte Intel Core UItra-Prozessor 22,26 Sekunden benötigte.

Es ist wichtig zu beachten, dass Intel die Meteor-Lake-Architektur (die Core-Ultra-CPUs antreibt) mit verschiedenen Rechenkacheln auf den Markt gebracht hat, wobei die NPU-Kachel (aufgebaut auf dem Intel 4-Knoten) für KI-Aufgaben auf dem Gerät konzipiert ist. Trotzdem liefert der ARM-betriebene Snapdragon X Elite 3x bessere KI-Leistung, hauptsächlich weil seine NPU allein 45 TOPS schaffen kann. Und in Kombination mit CPU, GPU und NPU ergibt sich eine Rechenleistung von bis zu 75 TOPS.

Schließlich arbeitet auch Qualcomm daran Hybride KI-Erlebnisse Dabei werden KI-Verarbeitungsaufgaben auf lokale Rechen- und Cloud-Ressourcen verteilt, um eine bessere Leistung zu bieten. Sie können Qualcomm AI Hub gleich hier ausprobieren (besuchen).

Was halten Sie also von Qualcomm AI Hub? Wird es neuartige generative KI-Erlebnisse auf dem Gerät anregen? Lassen Sie es uns im Kommentarbereich unten wissen.