Nachrichten

Samsung stapelt 12 Schichten leistungsstarken HBM3E-Speichers für bis zu 36 GB Kapazität

Samsung hat enthüllt Seine HBM3E-Speicherlösung der nächsten Generation bietet 12-Hi-Stacks für bis zu unglaubliche 36 GB Kapazität pro Stack.

Samsung wird mit seinem 12-Hi-Stack-HBM3E-Speicher mit bis zu 36 GB Kapazität pro Stack der ständig steigenden Nachfrage nach Speicherkapazität im KI-Segment gerecht

Pressemitteilung: Samsung Electronics gab heute bekannt, dass es HBM3E 12H entwickelt hat, den branchenweit ersten 12-Stack-HBM3E-DRAM und das bisher leistungsstärkste HBM-Produkt.

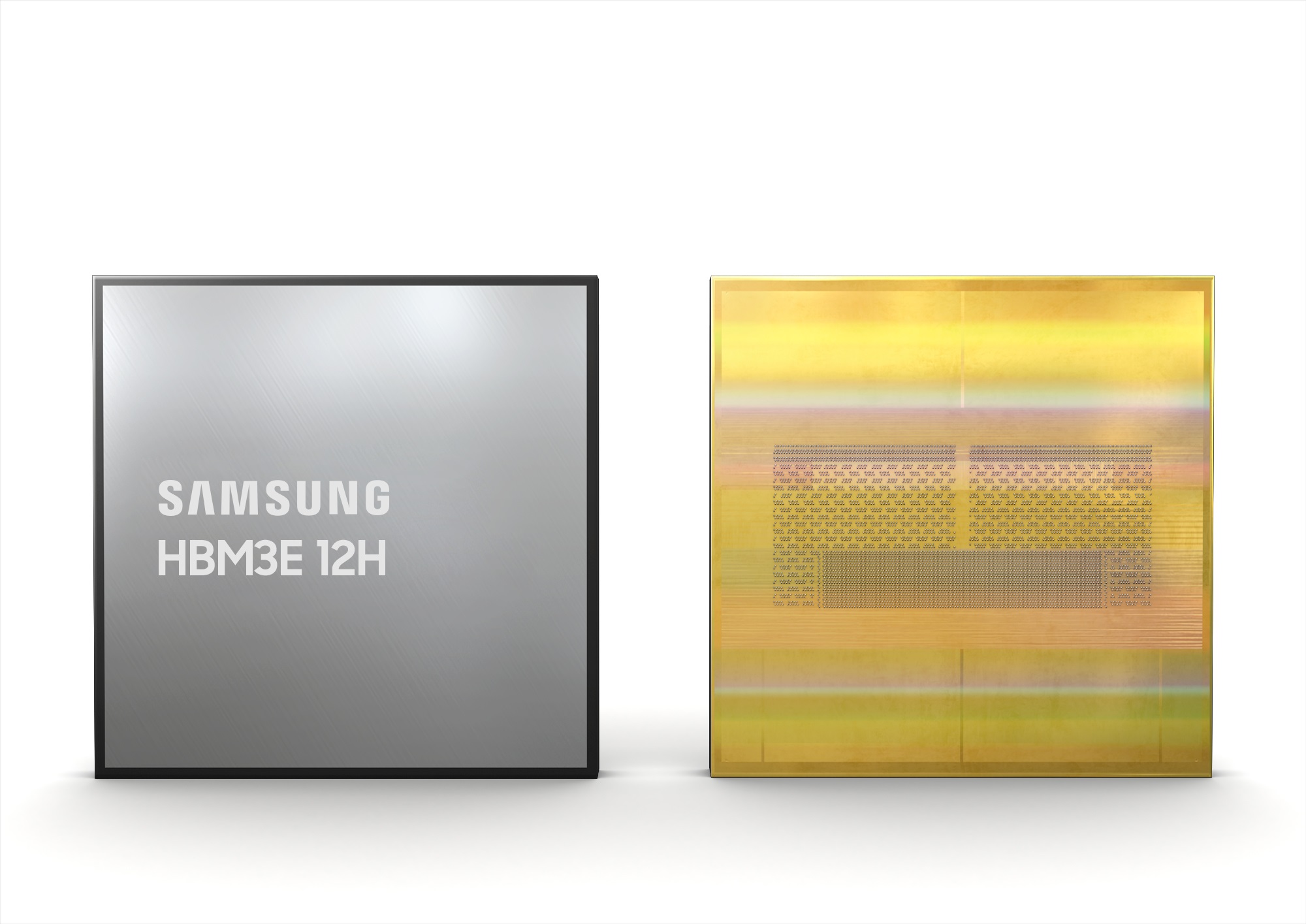

Der HBM3E 12H von Samsung bietet eine beispiellos hohe Bandbreite von bis zu 1.280 Gigabyte pro Sekunde (GB/s) und eine branchenführende Kapazität von 36 Gigabyte (GB). Im Vergleich zum 8-Stack HBM3 8H haben sich beide Aspekte um mehr als 50 % verbessert.

Beim HBM3E 12H wird eine hochentwickelte nichtleitende Thermokompressionsfolie (TC NCF) verwendet, sodass die 12-lagigen Produkte die gleichen Höhenspezifikationen wie die 8-lagigen haben und so die aktuellen HBM-Paketanforderungen erfüllen. Es wird erwartet, dass die Technologie insbesondere bei höheren Stapeln zusätzliche Vorteile bringt, da die Industrie versucht, die mit dünneren Chips einhergehende Chip-Die-Verformung zu verringern. Samsung hat die Dicke seines NCF-Materials weiter verringert und mit sieben Mikrometern (µm) den branchenweit kleinsten Abstand zwischen Chips erreicht, während gleichzeitig Hohlräume zwischen den Schichten beseitigt wurden. Diese Bemühungen führen zu einer um über 20 % verbesserten vertikalen Dichte im Vergleich zum Produkt HBM3 8H.

Samsungs fortschrittliches TC NCF verbessert auch die thermischen Eigenschaften des HBM, indem es die Verwendung von Bumps in verschiedenen Größen zwischen den Chips ermöglicht. Während des Chip-Bonding-Prozesses werden kleinere Bumps in Signalbereichen verwendet und größere an Stellen platziert, die eine Wärmeableitung erfordern. Diese Methode trägt auch zu einer höheren Produktausbeute bei.

Da KI-Anwendungen exponentiell wachsen, wird der HBM3E 12H voraussichtlich eine optimale Lösung für zukünftige Systeme sein, die mehr Speicher benötigen. Die höhere Leistung und Kapazität wird es Kunden insbesondere ermöglichen, ihre Ressourcen flexibler zu verwalten und die Gesamtbetriebskosten (TCO) für Rechenzentren zu senken. Beim Einsatz in KI-Anwendungen wird geschätzt, dass im Vergleich zur Einführung von HBM3 8H die durchschnittliche Geschwindigkeit für das KI-Training um 34 % gesteigert werden kann, während die Anzahl der gleichzeitigen Benutzer von Inferenzdiensten um mehr als das 11,5-fache erhöht werden kann.

Samsung hat mit der Bemusterung seines HBM3E 12H bei Kunden begonnen und die Massenproduktion ist für die erste Hälfte dieses Jahres geplant.